Proxmox VE 1.x: erinevus redaktsioonide vahel

Resümee puudub |

P Jj teisaldas lehekülje Proxmox pealkirja Proxmox VE 1.x alla ümbersuunamist maha jätmata |

||

| (ei näidata 2 kasutaja 199 vahepealset redaktsiooni) | |||

| 1. rida: | 1. rida: | ||

'''See tekst on hetkel veel toores''' | |||

===Sissejuhatus=== | |||

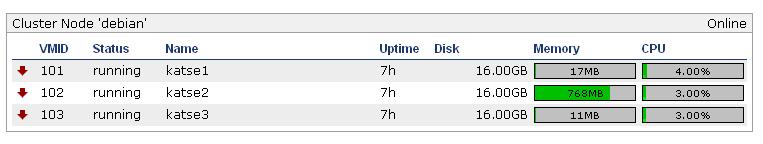

[[Pilt:Screenshot-3.png|200px|thumb|right|pilt3]] | |||

[[Pilt:Screenshot-2.png|200px|thumb|right|pilt2]] | |||

/etc/network/interfaces | [[Pilt:Screenshot-1.png|200px|thumb|right|pilt1]] | ||

[[Pilt:Screenshot.png|200px|thumb|right|pilt]] | |||

Proxmox on firma mis arendab Debianil ja vabavaral baseeruvaid serverilahendusi. Proxmox VE on Debianile loodud KVM ja OpenVZ tehnikale baseeruvate virtuaalserverite haldusplatform ehk alusdistro. Proxmox kuulub GPL litsentsi alla. | |||

'''NB! Käesolev tekst on kirjutatud pidades silmas Proxmox VE 1.x versioone, kuni 1.9 versioonini.''' | |||

'''Hilisemad 2.x versioonid on sellest väga erinevad''' | |||

[[Pilt:Proxmox Logo.jpg|300px]] | |||

Proxmox VEs sisalduvad võimalused: | |||

* Virtuaalmasinate võrgu boodi tugi gPXE abil http://www.etherboot.org/wiki/pxechaining | |||

* Lihtne kuid võimas veebiliides kus saab kõik põhilised seadistamised tehtud | |||

* Klusterdamise tugi | |||

* Virtuaalserverite mugav install ja kasutamine üle java konsooli | |||

===Install=== | |||

Installimiseks on kaks võimalust. Esimene (ja soovituslik) on tõmmata ametlik ISO fail ning paigaldada Proxmox selleabil. Juhend ja ISO tõmbamise lingid asuvad aadressil http://pve.proxmox.com/wiki/Installation | |||

Kui mingil põhjusel ametlikult plaadilt installimine ebaõnnestub. Näiteks ei tundnud minul seal leiduv Debian ära võrgukaarte ühe teatud kerneli bugi tõttu. Saab paigaldada käsitsi kõige uuema Debiani 64bitise versiooni, sest 32 bitil kahjuks rakendus ei tööta, ning sinna omakorda Proxmoxi paketi. Selleks esimese sammuna tuleks paigaldada tavaline Debian distro ja järgida edasi juhendit http://pve.proxmox.com/wiki/Install_Proxmox_VE_on_Debian_Lenny | |||

Avame /etc/apt/sources.list ja lisame sinna rea | |||

deb http://download.proxmox.com/debian lenny pve | |||

Lisame Proxmox VE repository key: | |||

# wget -O- "http://download.proxmox.com/debian/key.asc" | apt-key add - | |||

Uuendame süsteemi | |||

# aptitude update | |||

Ja paigaldame proxmoxi | |||

# aptitude install proxmox-ve-2.6.35 ntp ssh lvm2 | |||

Mis installib nii kerneli kui vajalikud utiliidid. | |||

The following NEW packages will be installed: | |||

proxmox-ve-2.6.35 pve-kernel-2.6.35-1-pve{a} | |||

Saadaolevaid versioone saab näha http://download.proxmox.com/debian/ saidilt. | |||

Kui Proxmox teatab "KVM module not loaded. Maybe you need to enable Intel VT / AMD-V support in the BIOS." Siis on tõenäoliselt virtualiseerimise tugi BIOSist keelatud või üldse arvutist puuduv. | |||

Lisainfot paigaldatud versioonide kohta saab käsuga: | |||

# pveversion -v | |||

pve-manager: 1.8-17 (pve-manager/1.8/5948) | |||

running kernel: 2.6.32-4-pve | |||

proxmox-ve-2.6.32: 1.8-33 | |||

pve-kernel-2.6.32-4-pve: 2.6.32-33 | |||

qemu-server: 1.1-30 | |||

pve-firmware: 1.0-11 | |||

libpve-storage-perl: 1.0-17 | |||

vncterm: 0.9-2 | |||

vzctl: 3.0.26-1pve4 | |||

vzdump: 1.2-12 | |||

vzprocps: 2.0.11-2 | |||

vzquota: 3.0.11-1 | |||

pve-qemu-kvm: 0.14.0-3 | |||

ksm-control-daemon: 1.0-5 | |||

Paigaldatud kerneli versioon toetab lisaks ka KSM nimelist tehnoloogiat mälukasutuse vähendamiseks virtuaalmasinatel http://pve.proxmox.com/wiki/KSM | |||

Nimetatud funktsioonist leiab veel juttu kerneli uuenduste loetelu juures http://kernelnewbies.org/Linux_2_6_32#head-d3f32e41df508090810388a57efce73f52660ccb | |||

Miks soovitatakse kasutada 32-bitiseid virtuaalmasinaid mitte 64 bitiseid ? | |||

64 bitine masin sobib vaid sellisel juhtudel kui vajad rohkem mälu kui 4GB. | |||

Samas 32bitine virtuaalmasin kasutab teatud situatsioonides vähem mälu. | |||

Näiteks standartselt paigaldatud apache2 kasutab 64 bitises opsüsteemis rohkem | |||

mälu kui ta teeks seda 32bitises. | |||

===Võrgu seadistus=== | |||

Probleem, meil on serveril üks võrgukaart ning tahame omistada | |||

sellele avaliku IP aadressi (192.168.0.1), lisaks aga ka teha üle selle virtuaalsete serveriteni bridge (silla) millekaudu pääsevad võrku ka kõik serveris resideeruvad virtuaalmasinad. | |||

Võrgu ehitust iseloomustab järgmine skeem | |||

[[Pilt:Vmb.jpg]] | |||

Sellejaoks avame faili /etc/network/interfaces | |||

auto vmbr0 | auto vmbr0 | ||

iface vmbr0 inet static | iface vmbr0 inet static | ||

address 192.168.0. | address 192.168.0.1 | ||

netmask 255.255.255.0 | netmask 255.255.255.0 | ||

gateway 192.168.0.254 | |||

bridge_ports eth0 | bridge_ports eth0 | ||

bridge_stp off | bridge_stp off | ||

bridge_fd 0 | bridge_fd 0 | ||

vmbr0 tuleb külge linuxitele esimese võrguseadme, ehk eth0ina | Ja ongi valmis. Server on ligipääsetav ip aadressilt 192.168.0.1 | ||

ning KVM virtuaalmasinate network kaardid võib siduda vmbr0 sillaga. Virtuaalmasinate sees võib tekkinud võrguseadmele omistada koheselt sama võrgu ip aadresse või DHCP teenuse olemasolu korral küsida IP aadresse. | |||

Soovides teha vmbr1 täiendavalt ilma igasuguse IP aadressita tuleb kirjutada see järgnevalt: | |||

auto vmbr1 | |||

iface vmbr1 inet manual | |||

bridge_ports eth1 | |||

bridge_stp off | |||

bridge_fd 0 | |||

Käsureal näeb jaotust | |||

# brctl show | |||

bridge name bridge id STP enabled interfaces | |||

vmbr0 8000.0026b93dea0b no eth1 | |||

vmtab102i0 | |||

vmtab103i0 | |||

vmtab104i0 | |||

vmtab105i0 | |||

vmbr1 8000.0026b93dea0a no eth0 | |||

vmtab102i1 | |||

vmtab103i1 | |||

vmtab104i1 | |||

vmtab105i1 | |||

vmtab106i1 | |||

Tähele tasub panna, et vmbr0 tuleb külge linuxitele esimese võrguseadme, ehk eth0ina, vmbr1 järgnevalt eth1na jne.. | |||

Peale võrguseadistuse muutmist tuleb teha kas restart või käivitada käsk: | |||

/etc/init.d/network restart | |||

Tulemüüri ehitamisel tuleb silmas pidada, et vaja on proxmoxi kasutamiseks hoida lahti järgnevad pordid. | |||

#Veebiliidese kasutamiseks: 443 | |||

#VNC veebikonsoolile: 5900-5999 | |||

#SSH ligipääsuks: 22 | |||

===iSCSI kasutamine=== | |||

iSCSI kasutamiseks tuleb installida pakett open-iscsi | |||

# apt-get install open-iscsi | |||

Ja seejärel tuleb teenused taaskäivitada | |||

# /etc/init.d/pvedaemon restart | |||

# /etc/init.d/apache2 restart | |||

Iscsi targeteid saab edaspidi külge haakida juba otse veebiliidesest. | |||

Kui iSCSI server mingil põhjusel enam ei suhtle siis veebiliidese | |||

kaudu iscsi kettaid lahti haakida pole võimalik. Sellisel juhul tuleb logida | |||

käsureale ja kustutada need manuaalselt failist /etc/pve/storage.cfg | |||

===Proxmox cluster=== | |||

NB! clustrisse pandavatel masinatel peab olema õige kelaaeg. Lisaks peavad | |||

virtuaalmasinate kettad olema haagitud kõikide nodede külge. Kettad saab sünkroniseerida klustri nodede vahel glusterfs või drdb abil või haakida need iscsi abil ühest suurest storageserverist. | |||

_____ master | |||

| | 192.168.1.1 | |||

|_____| | |||

| | |||

| | |||

-|---------|----------|----....---|-- | |||

| | | | |||

__|__ __|__ __|__ | |||

| | | | | | | |||

|_____| |_____| |_____| | |||

node1 node2 node3 | |||

192.168.1.2 192.168.1.3 192.168.1.4 | |||

Nodede ja masteri haldus käib pceca utiliidi abil | |||

USAGE: pveca -l # näitab clustri hetkeseisu | |||

pveca -c # tekita uus cluster ja muuda localhost master nodeks | |||

pveca -s [-h IP] # sünkroniseeri cluster vastu master nodet (või ip aadressi) | |||

pveca -d ID # kustuta node | |||

pveca -a [-h IP] # lisa uus node clustrisse | |||

pveca -m # sunni kohalikku node hakkama master nodeks | |||

Master node loomine masinal 192.168.1.1 | |||

# pveca -c | |||

Lisame slave noded clustrisse, ehk käivitame kõigil kolmel slavel järgneva käsu | |||

# pveca -a -h 192.168.1.1 | |||

Vaatame kas cluster hakkas tööle. | |||

# pveca -l | |||

CID----IPADDRESS----ROLE-STATE--------UPTIME---LOAD----MEM---ROOT---DATA | |||

1 : 192.168.1.1 M A 01:43 0.54 20% 1% 4% | |||

2 : 192.168.1.2 N A 05:02 0.04 26% 5% 29% | |||

3 : 192.168.1.3 N A 00:13 1.41 22% 3% 15% | |||

4 : 192.168.1.4 N A 00:05 0.54 17% 3% 3% | |||

Probleemide korral tuleb vahel kustutada fail /etc/pve/cluster.cfg ja node uuesti | |||

liita clustriga. | |||

===Proxmox DRBD cluster=== | |||

DRDB peamiseks miinuseks, et drdb clustrisse saab seadistada vaid kaks serverit mis toimivad mirrorina. | |||

Soovitatav on, et kettal või partitsioonil, kus virtuaalmasinad resideeruvad oleks eelnevalt seadistatud LVM | |||

*http://pve.proxmox.com/wiki/DRBD Ametlik seadistusjuhend | |||

*http://www.drbd.org/ DRBD ametlik kodulehekülg | |||

*http://kuutorvaja.eenet.ee/wiki/DRBD_kasutamine_Debianiga DRBD kasutamine Debianiga | |||

===Virtuaalserverite arhiveerimine ja taastamine=== | |||

Proxmoxi veebiliidesest on võimalik seda seadistada virtuaalserveritest nii automaatselt snapshotte kui täisvarukoopiaid tegema. Varundatud masinate taastamine toimbu käsureal vzrestore (OpenVZ) või qmrestore (KVM) käskudega. | |||

Põjalikuma juhendi leiab taas ametlikust wikist http://pve.proxmox.com/wiki/Backup_-_Restore_-_Live_Migration | |||

===Veebiliides=== | |||

Pöördudes http://192.168.0.1 aadressile peaks avanema veebiaken kus saab virtuaalseid masinaid luua ja hallata. Veebiliidese administraatori kasutajaks on "root" ja parooliks sama mis süsteemsel root kasutajal. | |||

Kui virtuaalmasinas (KVM) kasutatav operatsioonisüsteem seda toetab siis tasub kasutada võimalikult palju virtio seamdmeid (võrk, ketas), nendepoolt tekitatud väiksema overheadi tõttu sest siis pole vaja virtuaalserveril emuleerida mingit konkreetset rauda. | |||

Virtuaamasinate konsooli saad lahti, kui valid menüüst "Virtual Machines", klõpsad sind huvitaval masinal ja järmisel lehel on detailinfo VM-i kohta ning suhteliselt märkamatu lingike "Open VNC | |||

Console" (Reset, Shutdown, Stop nuppude all). Brauseris peab java lubatud olema. Kindlasti saab ka suvalise VNC kliendiga. | |||

===Guesti seadistusfaili kasutamine=== | |||

Seadistusfailid asuvad kaustas /etc/qemu-server/ | |||

Näiteks virtuaalmasina 101 konf asub failis /etc/qemu-server/101.conf ja näeb välja järgnev: | |||

name: testikas | |||

bootdisk: ide0 | |||

vlan1: rtl8139=42:D5:BD:2C:EC:79 | |||

ostype: other | |||

memory: 2024 | |||

sockets: 1 | |||

ide0: disk1:0.0.0.scsi-14945540000000000ebaf87d4e8aadc8f7c7cbd9b9b75a514 | |||

Vahel kui ei õnnestu virtuaalmasinat kustutada tuleb talt enne eemaldada | |||

kettad. näiteks esineb see probleem iscsi külgehaagitud seadmetega. | |||

====floppy ketta kasutamine==== | |||

# cat /etc/qemu-server/109.conf | |||

... | |||

args: -fda /root/109.floppy | |||

kus fail /root/109.floppy on tekitatud | |||

# dd if=/dev/zero of=/root/109.floppy bs=1024 count=1440 | |||

===KSM (Kernel Samepage Merging) ja KVM=== | |||

On older kernels you may need to set /sys/kernel/mm/ksm/max_kernel_pages, however on newer kernels all you need to do is to run: | |||

Kerneli seadistus juhul kui tegemist enda loodud kernelgia: | |||

Processor type and features ---> | |||

[*] Enable KSM for page merging | |||

# echo 1 > /sys/kernel/mm/ksm/run | |||

# apt-get install ksm-control-daemon | |||

*is the ksm control daemon running ('ksmtuned')?, If not, start with: | |||

# /etc/init.d/ksmtuned startˇ | |||

Seadistusfail /etc/ksmtuned.conf | |||

Kolm FreeBSD installi töötamas KVM virtuaalserverites ja kasutamas KSMi. | |||

[[Pilt:Ramikasutus.jpg]] | |||

# cat /sys/kernel/mm/ksm/pages_sharing | |||

169978 | |||

Once this value is greater than zero, you’re taking advantage of KSM. | |||

http://www.linux-kvm.com/content/using-ksm-kernel-samepage-merging-kvm | |||

http://pve.proxmox.com/wiki/KSM | |||

http://www.linux-kvm.com/content/using-ksm-kernel-samepage-merging-kvm | |||

http://docs.redhat.com/docs/en-US/Red_Hat_Enterprise_Linux/6/html/Virtualization_Administration_Guide/chap-KSM.html | |||

===Proxmox guesti riistvara=== | |||

TODO | |||

Vaikimisi on guestis kasutada selline nö riistvara | |||

# lspci | |||

00:00.0 Host bridge: Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02) | |||

00:01.0 ISA bridge: Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II] | |||

00:01.1 IDE interface: Intel Corporation 82371SB PIIX3 IDE [Natoma/Triton II] | |||

00:01.2 USB Controller: Intel Corporation 82371SB PIIX3 USB [Natoma/Triton II] (rev 01) | |||

00:01.3 Bridge: Intel Corporation 82371AB/EB/MB PIIX4 ACPI (rev 03) | |||

00:02.0 VGA compatible controller: Cirrus Logic GD 5446 | |||

00:03.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a | |||

00:04.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a | |||

00:05.0 Ethernet controller: Red Hat, Inc Virtio network device | |||

00:06.0 SCSI storage controller: Red Hat, Inc Virtio block device | |||

00:07.0 SCSI storage controller: Red Hat, Inc Virtio block device | |||

kus | |||

* LSI Logic SCSI kontroller | |||

* Cirrus Logi GD 5446 video adapter | |||

===Töötavale KVM guestile SCSI plokkseadme lisamine=== | |||

Töötavale KVM guestile SCSI plokkseadme lisamiseks peab | |||

* hostis olema ettevalmistatud vastav ressurss, nt LVM köide ja seejärel sobib qm monitoris öelda | |||

* guestis olema üks SCSI host adapter (kontroller), mis tekib nt kui guesti on seadistatud üks SCSI kõvaketas | |||

# qm monitor 116 | |||

qm> info block | |||

qm> drive_add 3 file=/dev/data/vm-116-disk-5,if=scsi | |||

kus | |||

* 3 - guesti lscpi väljundi järgi scsi host adapteri number | |||

guest# lspci | |||

00:00.0 Host bridge: Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02) | |||

00:01.0 ISA bridge: Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II] | |||

... | |||

00:03.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a | |||

* file=/dev/data/vm-116-disk-3 - ettevalmistatud LVM köide hostis | |||

* if=scsi - näidatakse, et töötatakse SCSI seadmega | |||

Seejärel tuleb re-skaneerida scsi seadmed scsitools paketis sisalduva rescan-scsi-bus utiliidiga, tulemusena ilmub uus /dev/sdc vms sissekanne | |||

guest # rescan-scsi-bus | |||

Plokkseadme guestist eemaldamiseks tuleb esmalt lõpetada guestis plokkseadme kasutamine ja öelda | |||

qm> info block | |||

scsi0-hd0: type=hd removable=0 file=/dev/data/vm-116-disk-3 ro=0 drv=raw encrypted=0 | |||

virtio0: type=hd removable=0 file=/dev/data/vm-116-disk-1 ro=0 drv=raw encrypted=0 | |||

virtio1: type=hd removable=0 file=/dev/data/vm-116-disk-2 ro=0 drv=raw encrypted=0 | |||

qm> drive_del scsi0-hd0 | |||

Guestist seadme /dev kataloogi sissekande eemaldamiseks sobib öelda | |||

# echo 1 > /sys/bus/scsi/drivers/sd/0\:0\:3\:0/delete | |||

lsscsi programmi väljund on samuti informatiivne | |||

# lsscsi | |||

[0:0:0:0] disk QEMU QEMU HARDDISK 0.14 /dev/sda | |||

[0:0:1:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdc | |||

[1:0:0:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdd | |||

[1:0:1:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdb | |||

kus neli esimest positsiooni tähistavad H:C:T:L väärtuste komplekte | |||

* H - host | |||

* C - channel | |||

* T - target | |||

* L - lun | |||

Kasulikud lisamaterjalid | |||

* http://www.linux-kvm.org/page/Hotadd_pci_devices | |||

* http://www.ibm.com/developerworks/wikis/display/LinuxP/SCSI+-+Hot+add,+remove,+rescan+of+SCSI+devices | |||

* http://docs.redhat.com/docs/en-US/Red_Hat_Enterprise_Linux/6/html/Storage_Administration_Guide/removing_devices.html | |||

===Proxmoxi konsoolipilt videoks=== | |||

Mul on pidevalt see häda, et Proxmoxi buutimise veateated kaovad ekraani serva taha ära ja kerida ei lase, et neid lugeda. | |||

Nüüd avastasin, et Proxmoxi kasutatav TightVNC lubab (kui Java lubab) ekraanistriimi salvestada faili RFB formaadis ja on proge nimega RFBProxy, mis suudab seda lugeda. | |||

Ekraanipildi salvestamiseks tuleb Proxmoxi konsooliaknas vajutada nuppu "Record", määrata failinimi, kuhu salvestada ja siis jälle "Record". | |||

Edasi sikutada programm RFBProxy: http://sourceforge.net/projects/rfbproxy | |||

Kompileerida ja siis lasta järgmine käsk käima | |||

$ rfbproxy -x vncsession.fbs.001| ffmpeg -r 60 -f image2pipe -vcodec ppm -i - -vcodec libx264 -vpre ultrafast -crf 20 -threads 0 -bf 0 -y vncsession.mp4 | |||

*-x võtmega sülitab rfbproxy sessiooni PPM formaadis stdouti ja ffmpegiga saab selle kenasti MP4 videoks keerata. | |||

Oma veateate sain igatahes ära lugeda. | |||

PS. Kui faili suurus on oluline, siis selle -crf võtme väärtust võib suurendada. Kuni 35 tundus veel tekst loetav olevat. | |||

===Märkused=== | |||

*Virtuaalmasinate haldamiseks on hea asi libvirt. Võimalik on kasutada juba mõnda selle otsa ehitatud liidest või teha ise endale sobiv liides. Libvirt suhtleb virtualiseerimiskihiga ja kasutaja ei pea väga muretsema, kas all on KVM, Xen või midagi muud. http://libvirt.org/ | |||

* lvm köitel peab olema kirjeldatud nn köite silt (ingl. k. tag), vastasel juhul nt haldusliideses ei ole näha virtuaalse arvuti plokkseadmete suurusi, http://pve.proxmox.com/wiki/Moving_disk_image_from_one_KVM_machine_to_another | |||

# lvcreate --addtag ... | |||

* Proxmox v. 1.8 juures mdadm raidi kasutamisel tuleb arvestada, et teatud juhtumitel võib mdadm lülituses viimase fdisk partitsiooni kasutamine eksitada mdadm'i sarnase teatega, http://fts.ifac.cnr.it/cgi-bin/dwww/usr/share/doc/mdadm/FAQ.gz | |||

mdadm: WARNING /dev/hdc3 and /dev/hdc appear to have very similar | |||

superblocks. If they are really different, please --zero the superblock on | |||

one. If they are the same or overlap, please remove one from the DEVICE | |||

list in mdadm.conf. | |||

FAQ.gz tekstis on kirjeldatud võimalikke lahendusi, üheks on täpselt näidata /etc/mdadm/mdadm.conf seadistusfailis kasutada olevate seadmete nimed. | |||

* Proxmox v. 1.8 juures dbbd8-utils ja kernel v. 2.6.35 kasutamisel tuleb arvestada, et drbd tarkvara user ja kernel space versioonid on erinevad | |||

* Proxmox ei kasuta shared storage ja LVM puhul CLVM deemonit, kuid väidetavalt lahendatakse see probleem muude vahenditega, http://forum.proxmox.com/archive/index.php/t-5207.html?s=3553954f01702c4378597ad8a56ff58f | |||

* Proxmox virtuaalsetele arvutitele ressurside eraldamisel on praktiliselt samaväärne anda cpu core või socket ressursse, erinevus on pigem administratiivne, nt mõnel juhul litsentsitingimuste tõttu võib guest näha kahte protsessorit kui talle on eraldatud neli cpu soketit ja igas üks core; samal ajal näeb guesti nelja protsessorit kui talle eraldada üks cpu socket milles on 4 core. | |||

* Proxmox KVM guestide klastri erinevad hostid voivad kasutada suhteliselt erinevat riistvara, nt üks AMD ja teine Intel protsessorit, erinevat hulka mälu jms. | |||

if Java is not on, install the Java Runtime Environment (JRE) in accordance with the operating system used The alternatives to using the Java plugin, we can activate one-time session to access VNC with a command console on Proxmox VE: nc-l-p 5900-c “qm vncproxy VMID PASSWORD” | |||

# nc-l-p 5900-c “qm vncproxy 101 mypassword” | |||

With the above command, automatically we can do a remote connection using the VNC application, for example using vncviewer or KRDC or RealVNC. | |||

Sertifikaadidn asuvad kaustas /etc/pve/ | |||

Täpsemalt on apaches need defineeritud: | |||

SSLCertificateFile /etc/pve/pve-ssl.pem | |||

SSLCertificateKeyFile /etc/pve/pve-ssl.key | |||

===Kasulikud lisamaterjalid=== | |||

* Proxmox ja mdadm RAID kasutamine - http://layer0.de/~kai/howto/proxmox/howto_proxmox_raid.html | |||

* Proxmox ja cryptsetup kasutamine - http://layer0.de/~kai/howto/proxmox/howto_proxmox_crypto.html | |||

* http://c-nergy.be/blog/?p=1658 Proxmox VE 2.0 versiooni ülevaade. | |||

http://kuutorvaja.eenet.ee/wiki/KVM_kasutamine_Debian_Lenniga KVM kasutamine Debian Lennyga | |||

http://kuutorvaja.eenet.ee/wiki/KVM_kasutamine_Ubuntu_10.04_operatsioonisüsteemiga KVM kasutamine Ubuntu 10.04 operatsioonisüsteemiga | |||

http://pve.proxmox.com/wiki/Main_Page Proxmoxi wiki | |||

http://en.wikipedia.org/wiki/Comparison_of_platform_virtual_machines Erinevate virtualiseerimise lahenduste wikipedia võrdlustabel | |||

Kaks linki virtuaalmasinate juures mälu kokkuhoiust | |||

http://avikivity.blogspot.com/2008/04/memory-overcommit-with-kvm.html | |||

http://www.linux-kvm.com/content/memory-ballooning-feature-coming-soon-kvm | |||

Viimane redaktsioon: 20. november 2016, kell 12:35

See tekst on hetkel veel toores

Sissejuhatus

Proxmox on firma mis arendab Debianil ja vabavaral baseeruvaid serverilahendusi. Proxmox VE on Debianile loodud KVM ja OpenVZ tehnikale baseeruvate virtuaalserverite haldusplatform ehk alusdistro. Proxmox kuulub GPL litsentsi alla.

NB! Käesolev tekst on kirjutatud pidades silmas Proxmox VE 1.x versioone, kuni 1.9 versioonini. Hilisemad 2.x versioonid on sellest väga erinevad

Proxmox VEs sisalduvad võimalused:

- Virtuaalmasinate võrgu boodi tugi gPXE abil http://www.etherboot.org/wiki/pxechaining

- Lihtne kuid võimas veebiliides kus saab kõik põhilised seadistamised tehtud

- Klusterdamise tugi

- Virtuaalserverite mugav install ja kasutamine üle java konsooli

Install

Installimiseks on kaks võimalust. Esimene (ja soovituslik) on tõmmata ametlik ISO fail ning paigaldada Proxmox selleabil. Juhend ja ISO tõmbamise lingid asuvad aadressil http://pve.proxmox.com/wiki/Installation

Kui mingil põhjusel ametlikult plaadilt installimine ebaõnnestub. Näiteks ei tundnud minul seal leiduv Debian ära võrgukaarte ühe teatud kerneli bugi tõttu. Saab paigaldada käsitsi kõige uuema Debiani 64bitise versiooni, sest 32 bitil kahjuks rakendus ei tööta, ning sinna omakorda Proxmoxi paketi. Selleks esimese sammuna tuleks paigaldada tavaline Debian distro ja järgida edasi juhendit http://pve.proxmox.com/wiki/Install_Proxmox_VE_on_Debian_Lenny

Avame /etc/apt/sources.list ja lisame sinna rea

deb http://download.proxmox.com/debian lenny pve

Lisame Proxmox VE repository key:

# wget -O- "http://download.proxmox.com/debian/key.asc" | apt-key add -

Uuendame süsteemi

# aptitude update

Ja paigaldame proxmoxi

# aptitude install proxmox-ve-2.6.35 ntp ssh lvm2

Mis installib nii kerneli kui vajalikud utiliidid.

The following NEW packages will be installed:

proxmox-ve-2.6.35 pve-kernel-2.6.35-1-pve{a}

Saadaolevaid versioone saab näha http://download.proxmox.com/debian/ saidilt.

Kui Proxmox teatab "KVM module not loaded. Maybe you need to enable Intel VT / AMD-V support in the BIOS." Siis on tõenäoliselt virtualiseerimise tugi BIOSist keelatud või üldse arvutist puuduv.

Lisainfot paigaldatud versioonide kohta saab käsuga:

# pveversion -v pve-manager: 1.8-17 (pve-manager/1.8/5948) running kernel: 2.6.32-4-pve proxmox-ve-2.6.32: 1.8-33 pve-kernel-2.6.32-4-pve: 2.6.32-33 qemu-server: 1.1-30 pve-firmware: 1.0-11 libpve-storage-perl: 1.0-17 vncterm: 0.9-2 vzctl: 3.0.26-1pve4 vzdump: 1.2-12 vzprocps: 2.0.11-2 vzquota: 3.0.11-1 pve-qemu-kvm: 0.14.0-3 ksm-control-daemon: 1.0-5

Paigaldatud kerneli versioon toetab lisaks ka KSM nimelist tehnoloogiat mälukasutuse vähendamiseks virtuaalmasinatel http://pve.proxmox.com/wiki/KSM

Nimetatud funktsioonist leiab veel juttu kerneli uuenduste loetelu juures http://kernelnewbies.org/Linux_2_6_32#head-d3f32e41df508090810388a57efce73f52660ccb

Miks soovitatakse kasutada 32-bitiseid virtuaalmasinaid mitte 64 bitiseid ? 64 bitine masin sobib vaid sellisel juhtudel kui vajad rohkem mälu kui 4GB. Samas 32bitine virtuaalmasin kasutab teatud situatsioonides vähem mälu. Näiteks standartselt paigaldatud apache2 kasutab 64 bitises opsüsteemis rohkem mälu kui ta teeks seda 32bitises.

Võrgu seadistus

Probleem, meil on serveril üks võrgukaart ning tahame omistada sellele avaliku IP aadressi (192.168.0.1), lisaks aga ka teha üle selle virtuaalsete serveriteni bridge (silla) millekaudu pääsevad võrku ka kõik serveris resideeruvad virtuaalmasinad.

Võrgu ehitust iseloomustab järgmine skeem

Sellejaoks avame faili /etc/network/interfaces

auto vmbr0

iface vmbr0 inet static

address 192.168.0.1

netmask 255.255.255.0

gateway 192.168.0.254

bridge_ports eth0

bridge_stp off

bridge_fd 0

Ja ongi valmis. Server on ligipääsetav ip aadressilt 192.168.0.1 ning KVM virtuaalmasinate network kaardid võib siduda vmbr0 sillaga. Virtuaalmasinate sees võib tekkinud võrguseadmele omistada koheselt sama võrgu ip aadresse või DHCP teenuse olemasolu korral küsida IP aadresse.

Soovides teha vmbr1 täiendavalt ilma igasuguse IP aadressita tuleb kirjutada see järgnevalt:

auto vmbr1

iface vmbr1 inet manual

bridge_ports eth1

bridge_stp off

bridge_fd 0

Käsureal näeb jaotust

# brctl show

bridge name bridge id STP enabled interfaces

vmbr0 8000.0026b93dea0b no eth1

vmtab102i0

vmtab103i0

vmtab104i0

vmtab105i0

vmbr1 8000.0026b93dea0a no eth0

vmtab102i1

vmtab103i1

vmtab104i1

vmtab105i1

vmtab106i1

Tähele tasub panna, et vmbr0 tuleb külge linuxitele esimese võrguseadme, ehk eth0ina, vmbr1 järgnevalt eth1na jne..

Peale võrguseadistuse muutmist tuleb teha kas restart või käivitada käsk:

/etc/init.d/network restart

Tulemüüri ehitamisel tuleb silmas pidada, et vaja on proxmoxi kasutamiseks hoida lahti järgnevad pordid.

- Veebiliidese kasutamiseks: 443

- VNC veebikonsoolile: 5900-5999

- SSH ligipääsuks: 22

iSCSI kasutamine

iSCSI kasutamiseks tuleb installida pakett open-iscsi

# apt-get install open-iscsi

Ja seejärel tuleb teenused taaskäivitada

# /etc/init.d/pvedaemon restart # /etc/init.d/apache2 restart

Iscsi targeteid saab edaspidi külge haakida juba otse veebiliidesest.

Kui iSCSI server mingil põhjusel enam ei suhtle siis veebiliidese kaudu iscsi kettaid lahti haakida pole võimalik. Sellisel juhul tuleb logida käsureale ja kustutada need manuaalselt failist /etc/pve/storage.cfg

Proxmox cluster

NB! clustrisse pandavatel masinatel peab olema õige kelaaeg. Lisaks peavad virtuaalmasinate kettad olema haagitud kõikide nodede külge. Kettad saab sünkroniseerida klustri nodede vahel glusterfs või drdb abil või haakida need iscsi abil ühest suurest storageserverist.

_____ master

| | 192.168.1.1

|_____|

|

|

-|---------|----------|----....---|--

| | |

__|__ __|__ __|__

| | | | | |

|_____| |_____| |_____|

node1 node2 node3

192.168.1.2 192.168.1.3 192.168.1.4

Nodede ja masteri haldus käib pceca utiliidi abil

USAGE: pveca -l # näitab clustri hetkeseisu

pveca -c # tekita uus cluster ja muuda localhost master nodeks

pveca -s [-h IP] # sünkroniseeri cluster vastu master nodet (või ip aadressi)

pveca -d ID # kustuta node

pveca -a [-h IP] # lisa uus node clustrisse

pveca -m # sunni kohalikku node hakkama master nodeks

Master node loomine masinal 192.168.1.1

# pveca -c

Lisame slave noded clustrisse, ehk käivitame kõigil kolmel slavel järgneva käsu

# pveca -a -h 192.168.1.1

Vaatame kas cluster hakkas tööle.

# pveca -l CID----IPADDRESS----ROLE-STATE--------UPTIME---LOAD----MEM---ROOT---DATA 1 : 192.168.1.1 M A 01:43 0.54 20% 1% 4% 2 : 192.168.1.2 N A 05:02 0.04 26% 5% 29% 3 : 192.168.1.3 N A 00:13 1.41 22% 3% 15% 4 : 192.168.1.4 N A 00:05 0.54 17% 3% 3%

Probleemide korral tuleb vahel kustutada fail /etc/pve/cluster.cfg ja node uuesti liita clustriga.

Proxmox DRBD cluster

DRDB peamiseks miinuseks, et drdb clustrisse saab seadistada vaid kaks serverit mis toimivad mirrorina.

Soovitatav on, et kettal või partitsioonil, kus virtuaalmasinad resideeruvad oleks eelnevalt seadistatud LVM

- http://pve.proxmox.com/wiki/DRBD Ametlik seadistusjuhend

- http://www.drbd.org/ DRBD ametlik kodulehekülg

- http://kuutorvaja.eenet.ee/wiki/DRBD_kasutamine_Debianiga DRBD kasutamine Debianiga

Virtuaalserverite arhiveerimine ja taastamine

Proxmoxi veebiliidesest on võimalik seda seadistada virtuaalserveritest nii automaatselt snapshotte kui täisvarukoopiaid tegema. Varundatud masinate taastamine toimbu käsureal vzrestore (OpenVZ) või qmrestore (KVM) käskudega.

Põjalikuma juhendi leiab taas ametlikust wikist http://pve.proxmox.com/wiki/Backup_-_Restore_-_Live_Migration

Veebiliides

Pöördudes http://192.168.0.1 aadressile peaks avanema veebiaken kus saab virtuaalseid masinaid luua ja hallata. Veebiliidese administraatori kasutajaks on "root" ja parooliks sama mis süsteemsel root kasutajal.

Kui virtuaalmasinas (KVM) kasutatav operatsioonisüsteem seda toetab siis tasub kasutada võimalikult palju virtio seamdmeid (võrk, ketas), nendepoolt tekitatud väiksema overheadi tõttu sest siis pole vaja virtuaalserveril emuleerida mingit konkreetset rauda.

Virtuaamasinate konsooli saad lahti, kui valid menüüst "Virtual Machines", klõpsad sind huvitaval masinal ja järmisel lehel on detailinfo VM-i kohta ning suhteliselt märkamatu lingike "Open VNC Console" (Reset, Shutdown, Stop nuppude all). Brauseris peab java lubatud olema. Kindlasti saab ka suvalise VNC kliendiga.

Guesti seadistusfaili kasutamine

Seadistusfailid asuvad kaustas /etc/qemu-server/

Näiteks virtuaalmasina 101 konf asub failis /etc/qemu-server/101.conf ja näeb välja järgnev:

name: testikas bootdisk: ide0 vlan1: rtl8139=42:D5:BD:2C:EC:79 ostype: other memory: 2024 sockets: 1 ide0: disk1:0.0.0.scsi-14945540000000000ebaf87d4e8aadc8f7c7cbd9b9b75a514

Vahel kui ei õnnestu virtuaalmasinat kustutada tuleb talt enne eemaldada kettad. näiteks esineb see probleem iscsi külgehaagitud seadmetega.

floppy ketta kasutamine

# cat /etc/qemu-server/109.conf ... args: -fda /root/109.floppy

kus fail /root/109.floppy on tekitatud

# dd if=/dev/zero of=/root/109.floppy bs=1024 count=1440

KSM (Kernel Samepage Merging) ja KVM

On older kernels you may need to set /sys/kernel/mm/ksm/max_kernel_pages, however on newer kernels all you need to do is to run:

Kerneli seadistus juhul kui tegemist enda loodud kernelgia:

Processor type and features --->

[*] Enable KSM for page merging

# echo 1 > /sys/kernel/mm/ksm/run

# apt-get install ksm-control-daemon

- is the ksm control daemon running ('ksmtuned')?, If not, start with:

# /etc/init.d/ksmtuned startˇ

Seadistusfail /etc/ksmtuned.conf

Kolm FreeBSD installi töötamas KVM virtuaalserverites ja kasutamas KSMi.

# cat /sys/kernel/mm/ksm/pages_sharing 169978

Once this value is greater than zero, you’re taking advantage of KSM.

http://www.linux-kvm.com/content/using-ksm-kernel-samepage-merging-kvm

http://pve.proxmox.com/wiki/KSM

http://www.linux-kvm.com/content/using-ksm-kernel-samepage-merging-kvm

Proxmox guesti riistvara

TODO

Vaikimisi on guestis kasutada selline nö riistvara

# lspci 00:00.0 Host bridge: Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02) 00:01.0 ISA bridge: Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II] 00:01.1 IDE interface: Intel Corporation 82371SB PIIX3 IDE [Natoma/Triton II] 00:01.2 USB Controller: Intel Corporation 82371SB PIIX3 USB [Natoma/Triton II] (rev 01) 00:01.3 Bridge: Intel Corporation 82371AB/EB/MB PIIX4 ACPI (rev 03) 00:02.0 VGA compatible controller: Cirrus Logic GD 5446 00:03.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a 00:04.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a 00:05.0 Ethernet controller: Red Hat, Inc Virtio network device 00:06.0 SCSI storage controller: Red Hat, Inc Virtio block device 00:07.0 SCSI storage controller: Red Hat, Inc Virtio block device

kus

- LSI Logic SCSI kontroller

- Cirrus Logi GD 5446 video adapter

Töötavale KVM guestile SCSI plokkseadme lisamine

Töötavale KVM guestile SCSI plokkseadme lisamiseks peab

- hostis olema ettevalmistatud vastav ressurss, nt LVM köide ja seejärel sobib qm monitoris öelda

- guestis olema üks SCSI host adapter (kontroller), mis tekib nt kui guesti on seadistatud üks SCSI kõvaketas

# qm monitor 116 qm> info block qm> drive_add 3 file=/dev/data/vm-116-disk-5,if=scsi

kus

- 3 - guesti lscpi väljundi järgi scsi host adapteri number

guest# lspci 00:00.0 Host bridge: Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02) 00:01.0 ISA bridge: Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II] ... 00:03.0 SCSI storage controller: LSI Logic / Symbios Logic 53c895a

- file=/dev/data/vm-116-disk-3 - ettevalmistatud LVM köide hostis

- if=scsi - näidatakse, et töötatakse SCSI seadmega

Seejärel tuleb re-skaneerida scsi seadmed scsitools paketis sisalduva rescan-scsi-bus utiliidiga, tulemusena ilmub uus /dev/sdc vms sissekanne

guest # rescan-scsi-bus

Plokkseadme guestist eemaldamiseks tuleb esmalt lõpetada guestis plokkseadme kasutamine ja öelda

qm> info block scsi0-hd0: type=hd removable=0 file=/dev/data/vm-116-disk-3 ro=0 drv=raw encrypted=0 virtio0: type=hd removable=0 file=/dev/data/vm-116-disk-1 ro=0 drv=raw encrypted=0 virtio1: type=hd removable=0 file=/dev/data/vm-116-disk-2 ro=0 drv=raw encrypted=0 qm> drive_del scsi0-hd0

Guestist seadme /dev kataloogi sissekande eemaldamiseks sobib öelda

# echo 1 > /sys/bus/scsi/drivers/sd/0\:0\:3\:0/delete

lsscsi programmi väljund on samuti informatiivne

# lsscsi [0:0:0:0] disk QEMU QEMU HARDDISK 0.14 /dev/sda [0:0:1:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdc [1:0:0:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdd [1:0:1:0] disk QEMU QEMU HARDDISK 0.14 /dev/sdb

kus neli esimest positsiooni tähistavad H:C:T:L väärtuste komplekte

- H - host

- C - channel

- T - target

- L - lun

Kasulikud lisamaterjalid

- http://www.linux-kvm.org/page/Hotadd_pci_devices

- http://www.ibm.com/developerworks/wikis/display/LinuxP/SCSI+-+Hot+add,+remove,+rescan+of+SCSI+devices

- http://docs.redhat.com/docs/en-US/Red_Hat_Enterprise_Linux/6/html/Storage_Administration_Guide/removing_devices.html

Proxmoxi konsoolipilt videoks

Mul on pidevalt see häda, et Proxmoxi buutimise veateated kaovad ekraani serva taha ära ja kerida ei lase, et neid lugeda. Nüüd avastasin, et Proxmoxi kasutatav TightVNC lubab (kui Java lubab) ekraanistriimi salvestada faili RFB formaadis ja on proge nimega RFBProxy, mis suudab seda lugeda.

Ekraanipildi salvestamiseks tuleb Proxmoxi konsooliaknas vajutada nuppu "Record", määrata failinimi, kuhu salvestada ja siis jälle "Record".

Edasi sikutada programm RFBProxy: http://sourceforge.net/projects/rfbproxy Kompileerida ja siis lasta järgmine käsk käima

$ rfbproxy -x vncsession.fbs.001| ffmpeg -r 60 -f image2pipe -vcodec ppm -i - -vcodec libx264 -vpre ultrafast -crf 20 -threads 0 -bf 0 -y vncsession.mp4

- -x võtmega sülitab rfbproxy sessiooni PPM formaadis stdouti ja ffmpegiga saab selle kenasti MP4 videoks keerata.

Oma veateate sain igatahes ära lugeda.

PS. Kui faili suurus on oluline, siis selle -crf võtme väärtust võib suurendada. Kuni 35 tundus veel tekst loetav olevat.

Märkused

- Virtuaalmasinate haldamiseks on hea asi libvirt. Võimalik on kasutada juba mõnda selle otsa ehitatud liidest või teha ise endale sobiv liides. Libvirt suhtleb virtualiseerimiskihiga ja kasutaja ei pea väga muretsema, kas all on KVM, Xen või midagi muud. http://libvirt.org/

- lvm köitel peab olema kirjeldatud nn köite silt (ingl. k. tag), vastasel juhul nt haldusliideses ei ole näha virtuaalse arvuti plokkseadmete suurusi, http://pve.proxmox.com/wiki/Moving_disk_image_from_one_KVM_machine_to_another

# lvcreate --addtag ...

- Proxmox v. 1.8 juures mdadm raidi kasutamisel tuleb arvestada, et teatud juhtumitel võib mdadm lülituses viimase fdisk partitsiooni kasutamine eksitada mdadm'i sarnase teatega, http://fts.ifac.cnr.it/cgi-bin/dwww/usr/share/doc/mdadm/FAQ.gz

mdadm: WARNING /dev/hdc3 and /dev/hdc appear to have very similar superblocks. If they are really different, please --zero the superblock on one. If they are the same or overlap, please remove one from the DEVICE list in mdadm.conf.

FAQ.gz tekstis on kirjeldatud võimalikke lahendusi, üheks on täpselt näidata /etc/mdadm/mdadm.conf seadistusfailis kasutada olevate seadmete nimed.

- Proxmox v. 1.8 juures dbbd8-utils ja kernel v. 2.6.35 kasutamisel tuleb arvestada, et drbd tarkvara user ja kernel space versioonid on erinevad

- Proxmox ei kasuta shared storage ja LVM puhul CLVM deemonit, kuid väidetavalt lahendatakse see probleem muude vahenditega, http://forum.proxmox.com/archive/index.php/t-5207.html?s=3553954f01702c4378597ad8a56ff58f

- Proxmox virtuaalsetele arvutitele ressurside eraldamisel on praktiliselt samaväärne anda cpu core või socket ressursse, erinevus on pigem administratiivne, nt mõnel juhul litsentsitingimuste tõttu võib guest näha kahte protsessorit kui talle on eraldatud neli cpu soketit ja igas üks core; samal ajal näeb guesti nelja protsessorit kui talle eraldada üks cpu socket milles on 4 core.

- Proxmox KVM guestide klastri erinevad hostid voivad kasutada suhteliselt erinevat riistvara, nt üks AMD ja teine Intel protsessorit, erinevat hulka mälu jms.

if Java is not on, install the Java Runtime Environment (JRE) in accordance with the operating system used The alternatives to using the Java plugin, we can activate one-time session to access VNC with a command console on Proxmox VE: nc-l-p 5900-c “qm vncproxy VMID PASSWORD”

# nc-l-p 5900-c “qm vncproxy 101 mypassword”

With the above command, automatically we can do a remote connection using the VNC application, for example using vncviewer or KRDC or RealVNC.

Sertifikaadidn asuvad kaustas /etc/pve/

Täpsemalt on apaches need defineeritud:

SSLCertificateFile /etc/pve/pve-ssl.pem SSLCertificateKeyFile /etc/pve/pve-ssl.key

Kasulikud lisamaterjalid

- Proxmox ja mdadm RAID kasutamine - http://layer0.de/~kai/howto/proxmox/howto_proxmox_raid.html

- Proxmox ja cryptsetup kasutamine - http://layer0.de/~kai/howto/proxmox/howto_proxmox_crypto.html

- http://c-nergy.be/blog/?p=1658 Proxmox VE 2.0 versiooni ülevaade.

http://kuutorvaja.eenet.ee/wiki/KVM_kasutamine_Debian_Lenniga KVM kasutamine Debian Lennyga

http://kuutorvaja.eenet.ee/wiki/KVM_kasutamine_Ubuntu_10.04_operatsioonisüsteemiga KVM kasutamine Ubuntu 10.04 operatsioonisüsteemiga

http://pve.proxmox.com/wiki/Main_Page Proxmoxi wiki

http://en.wikipedia.org/wiki/Comparison_of_platform_virtual_machines Erinevate virtualiseerimise lahenduste wikipedia võrdlustabel

Kaks linki virtuaalmasinate juures mälu kokkuhoiust

http://avikivity.blogspot.com/2008/04/memory-overcommit-with-kvm.html

http://www.linux-kvm.com/content/memory-ballooning-feature-coming-soon-kvm